<sorry Dutchies.. this one is in English… sort of..>

My fellow Datacenter Pulse (DCP) colleague Mark Thiele wrote a good article on the use of PUE in the datacenter industry. He basically argues that you should look at the TCO of the datacenter and have a holistic view (like we promote with the DCP stack)

He opens with the ‘my PUE is better than yours remark’ we see going around in the industry. This is mentioned before by the Green Grid; the misuse of PUE. (I have written several articles about this issue on my Dutch datacenter blog)

Well guess what… we kinda created this monster ourselves;

Commodity

Datacenter are going commodity. Differentiation is in efficiency; looking at all the signs in the datacenter industry: the datacenter is becoming a commodity. The general idea is that any successful product will end up a commodity. See Simon Wardley’s excellent presentations on this subject.

Example signs are:

(got lots more, but for an other blog and beyond the point now…)

Most of this leads to technology being available to everyone. You still need a big budget to start building a datacenter but cost is coming down thanks to advances in IT technology (like: do we still need to build TIER4?) and facility technology. Great example is the option to build modular and from an assembly line. This reduces datacenter production cost and you can spread CAPEX across time.

For any commodity product the competitive advantage diminishes, prices go down and if you’re in the market of selling the stuff: your differentiation is on price and efficiency.

So we push towards efficiency and lowering our operational cost, to be cheaper that the competition. It doesn’t matter what type of datacenter owner you are (enterprise, cloud, co-lo, whole sale..) the competitive advantage is in the operational cost. Everyone already has a SAS70, ISO27001, ISO9001, PCI, etc.. certificate. Everyone can get and build the technology and at some point it doesn’t pay off to worry about the small engineering details anymore; the cost are too high to get enough competitive advantage in return.

Marketing & Sales

If you’re in the datacenter co-lo or whole-sales business then your marketing and sales guys are trying to look for the (next) USP.

With the datacenter efficiency on the rise, it’s nice to have a single figure to tell your customer you are more efficient that the competition (and able to offer lower prices with it..).

PUE presented a great opportunity to get a nice USP for our sales guys. And I can’t blame them: it’s hard to sell a (going) commodity product and it’s something our customers are asking for.

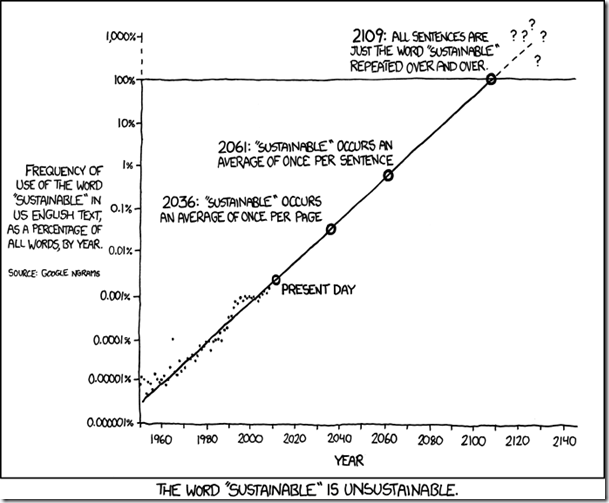

Sustainable & marketing

The whole ‘green wash/hype’ (before the economic crisis) added to the misuse of PUE from a sales and marketing perspective. Everyone was, and still is, building the next greenest datacenter on this planet. It would be nice to have a single figure to promote this ‘green stuff’ and tell the world about this new engineering marvel… and PUE is happily adopted for this.

On the enterprise/cloud datacenter owners side it’s not very different.. it’s just another angle. Especially the larger datacenter (cloud) owners are pushed from a marketing perspective thanks to organizations like Greenpeace. They demand full disclosure of datacenter energy use and sustainability on behalf of the world’s population.

PUE is a nice tool to get some of the pressure off and tell the world you have the greenest datacenter operation, like Facebook, Google, Microsoft and others are now doing. The problem with those numbers is they don’t say anything without the full context. And like Mark says in his article; it doesn’t say anything about the full datacenter stack.

Sustainable & Government

The really interesting thing I have been dealing with recently is government and PUE.

Many state and local government organizations are looking at datacenters from an energy use perspective. This focus is thanks to reports from research and governmental institutes (for example EPA) and organizations like Greenpeace.

Government can either use the ‘carrot (subsidies) or stick (penalties)’ approach but it always requires some kind of regulation and some form of measurement. They happily adapted PUE for this.

The main problem with this is that PUE is not ready to be audited. Sure general guidelines for PUE calculation are available, but it still doesn’t have all the full details and leaves opportunity to ‘game the system’. It also doesn’t address the full holistic datacenter approach and the fact that you cannot use PUE to compare different datacenters.

Datacenter customer

Some of the governmental organizations are also using PUE for their co-lo tenders. And they are not the only ones. More and more RFP’s on the datacenter market state a specific PUE number or target with additional credits for the lowest number.

I can’t blame the datacenter customer; the datacenter is a pretty complex facility box if you’re not educated in that industry. It would be nice to just throw some numbers at it like TIER1-4 and PUE1-2 and select the best solution provider on the market…

I can’t blame the datacenter owner for the answer with ‘the best possible number he can think of’… they just want the business…

Datacenter vendor

As usual I’m part of the problem also. When I go shopping for the next big thing in datacenter technology, PUE is always part of the conversation.

Datacenter equipment vendors (especially cooling and power) are happy to throw some numbers my way to convince me that their solution is the most efficient.

The PUE numbers are on the equipment spec sheets, on the vendor website and in the sales meeting… but at the end I always have to conclude that our little number dance really doesn’t tell me anything. Just like Mark mentions: I go back to TCO.

Our own monster

So… we created this monster as a datacenter industry. Owners and consumers. Government and industry groups. I can also assure you that this will continue and will also happen to some of the great other Green Grid initiatives like CUE, WUE and the Maturity Model. It’s just a way of trying to put a number on what can be a very complex stack of functions called ‘the datacenter’.

Only way to diminish the monster is to educate our industry colleagues and our customers. And stop throwing the numbers around…

For the record1: the use of PUE

Don’t get me wrong, I love PUE and have used it successfully many times to benchmark my own data centers and prove to senior management that we progressed in efficiency. It’s also the way the EU Datacenter Code of Conduct works: show progress every year by calculating the PUE for the same datacenter with the same calculation method. This way you will have apples – apples situation.

Its just that I don’t like the way PUE is used in the above examples…

For the record2: On datacenter and green

Full disclosure: Datacenters are not green and will never be green. They consume large amounts of energy and will consume more energy in the future. All thanks to Jevons Paradox and the fact that we start to consume more CPU/Storage if prices go down…. And yes, someone has to build datacenters for all the CPU’s and disk’s…

See GreenMonk – Simon Wardley on ‘Cloud & Green’

I do think that:

1. We should aim to build the most efficient datacenters on the planet. It should not only focus on energy consumption but on all resources used for build and operation.

2. We cannot keep up with the rising demand from an energy-grid perspective. We should start looking for alternative ways for datacenter builds and deployment.

De Green Grid heeft een nieuw whitepaper uitgebracht:

De Green Grid heeft een nieuw whitepaper uitgebracht: